由于机器人系统存在所谓的"策略脆弱",使所学习的机器人控制策略通常不能有效地适应工作环境或机器人本身的突然变化。与此形成鲜明对比的是拥有强大自愈能力的海豚Echo,就算是被鲨鱼咬掉篮球大的一块肉,海豚也能继续基本正常生活,且迅速自我修复,不留一点疤痕(图1)。

图1

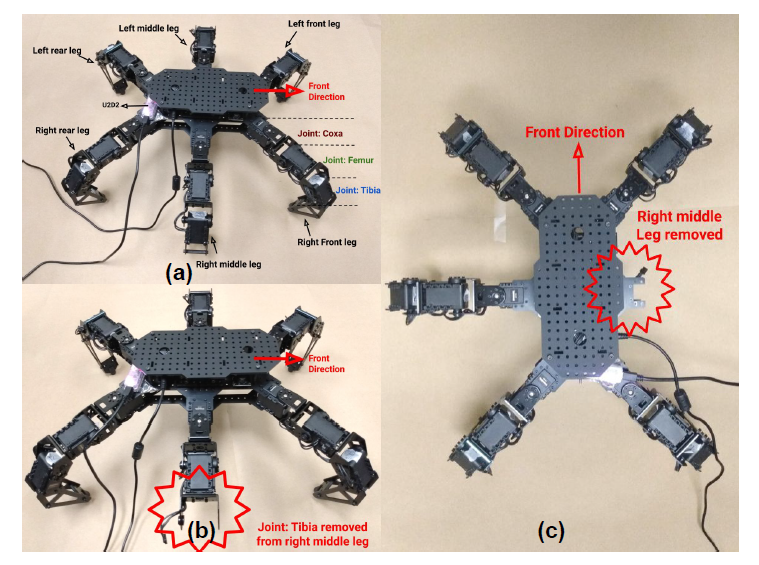

其实大多数活体动物在受伤时都可以迅速康复并找到补偿行为,受此现象的启发,UCF的学者研究了当遇到关节物理损坏或自由度随机丢失等阻碍时,机器人如何有效地进行适应学习以完成任务(图2)。

图2:(a):用于实验的 18自由度六足动物 (b):一个自由度减少导致失败 (c):全截肢,减少三个自由度和重量导致失败

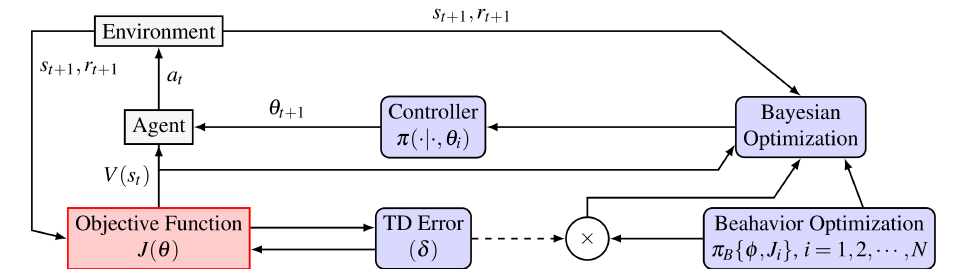

从数学的角度,这些机械故障都可以被抽象为状态空间S或动作空间A的损失,基于此他们提出了可生存的强化学习(Survivable Reinforcement Learning,SRL)框架(图3),通过贝叶斯先验作为未来策略学习的引导偏差,从而为机器人构建优化的运动策略。

图3 SRL整体框架

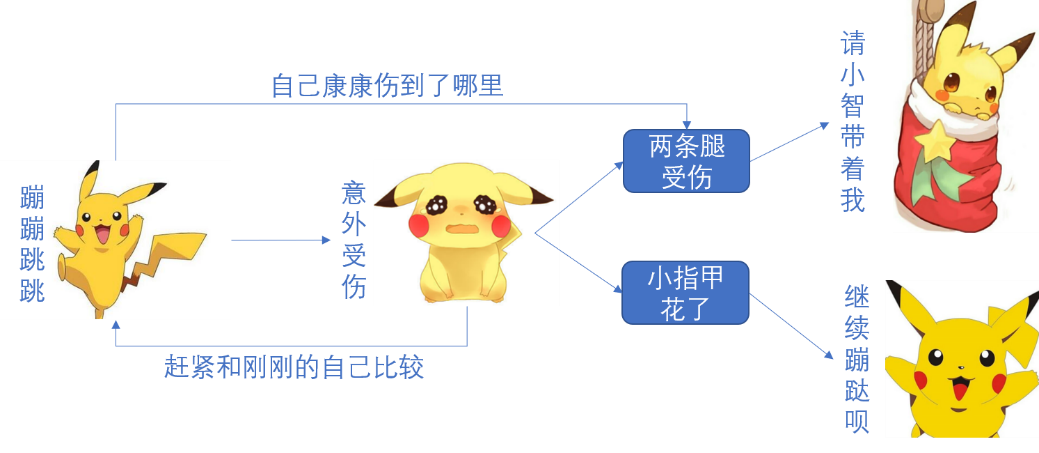

SRL的目标就是对从先前策略中学到的样本进行生成性开发,关键思想是使用参数后验估计(贝叶斯强化学习)来指导新策略的搜索方向,同时尽可能多地利用基础的策略。通俗点说就是,通过让机器人将自己现在和先前的身体状态进行比较,从而判断自己 “伤势”,从而再决定以多大比例再按照健康时候的动作继续执行任务。(图4)

图4 皮卡丘的强化生存学习过程

该算法的主要创新点在于将贝叶斯学习与最新的深度强化学习算法结合从而达到1+1>2的效果,同时也规避了现存的机器人损伤恢复和突发扰动规划面临的高成本且难度大等问题。他们的方案为机器人在存在动态约束的环境和遇到随机故障时的工作的应用提供了希望,最终的演示视频如下。

在未来的研究中,他们希望将提出的的 SRL 算法应用于具有高自由度且在动态约束下运行的多机器人系统,从而更进一步研究对环境中任何机器人具有不确定的物理损害时系统的自主适应能力。我认为提升机器人的自救能力是一项非常有价值的研究,就像不久前的佛罗里达州瑟夫赛德的12层公寓大楼部分倒塌(图5)。

IEEE RAS上的一篇文章以“为什么不能指望机器人在佛罗里达大楼倒塌中寻找幸存者”为题对现存救援机器人的问题进行分析,其中一个主要的原因就是面对复杂的灾难现场,很有可能发生意外情况(如石板坍塌)损伤机器人从而导致救援失败,由此可见研发具备“自愈”能力的机器人意义非凡,现在机器人领域关于这方面的研究蔚然成风,我相信将“生存”技术用于真正的救援机器人指日可待!!!

图5 佛罗里达州瑟夫赛德的12层公寓大楼倒塌现状

参考:

[1] https://www.zhihu.com/question/20950308

评论(0)

您还未登录,请登录后发表或查看评论