一、A-SCN

原文链接:Attentional ShapeContextNet for Point Cloud Recognition | IEEE Conference Publication | IEEE Xplore

这篇文章提出了一个新的网络结构SCN(本文不过多关注):

引入注意力后即A-SCN。下图为A-SCN块结构(图中标注的第一个好像应为

):

二、Point Attention

原文链接:https://arxiv.org/pdf/1909.12663.pdf

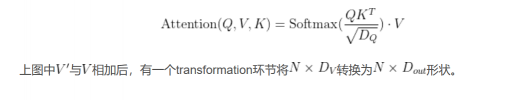

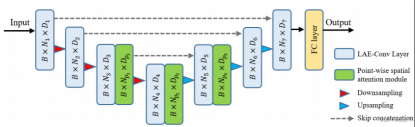

本文提出了新的网络结构LAE-Conv,然后将其输出特征输入到下列结构:

将上述注意力机制嵌入网络中,得到本文的Point Attention网络如下:

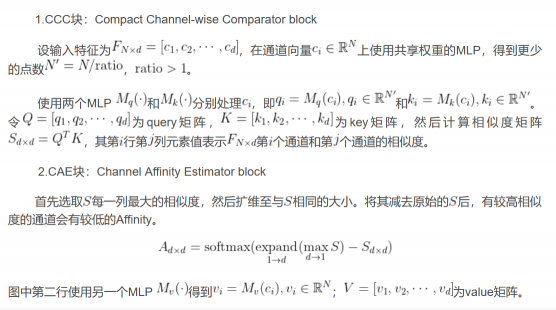

三、CAA

原文链接:https://arxiv.org/pdf/1911.12885.pdf

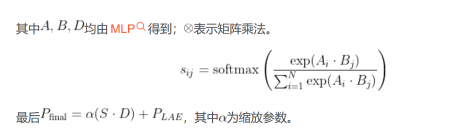

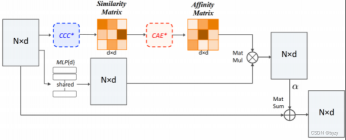

同样也是先提出一种网络结构,再将特征输入下图所示的CAA模块:

该图大致分为三行,第一行包含CCC块和CAE块:

图中第三行使用残差连接,并学习一个权重来使学习变得容易。最终的输出为

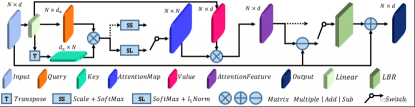

四、Offset Attention

原文链接:https://arxiv.org/pdf/2012.09688.pdf

同样先提出PCT(点云Transformer)结构,这里仅关注其中的注意力部分。

Offset Attention图示:

图中两个开关均往上时为自注意力(SA);均往下时为offset attention;LBR表示线性层,BN和ReLU。

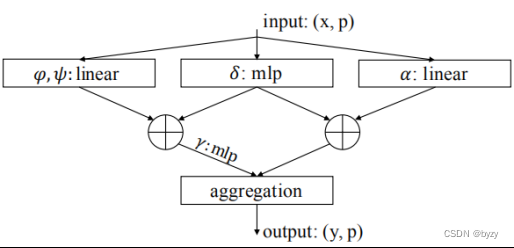

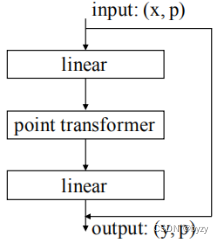

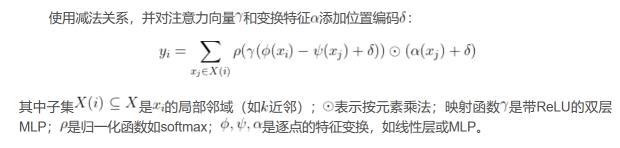

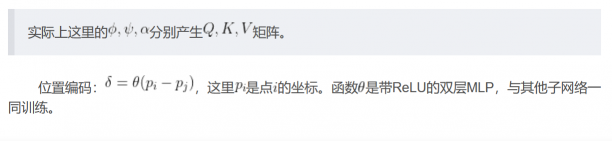

五、Point Transformer

原文链接:https://arxiv.org/pdf/2012.09164.pdf

评论(0)

您还未登录,请登录后发表或查看评论